Thermodynamique statistique

1. Notions fondamentales

1.a. Micro et macro-états

Un système thermodynamique est un système comportant un nombre de constituants élémentaires très grand, en pratique de l'ordre du nombre d'Avogadro.

Nous allons raisonner sur un exemple particulier : un gaz parfait monoatomique, que l'on modélisera par N atomes ponctuels, occupant un volume V fermé et formant un système isolé d'énergie E. On suppose que ces atomes obéissent aux lois de Newton de la mécanique (gaz parfait classique). Chaque atome a donc une trajectoire : on peut à tout instant définir sa position dans l'espace et sa vitesse. Pour un gaz parfait, l'énergie est la somme des énergies cinétiques des atomes :

L'état d'un atome à un instant donné est entièrement défini par sa position (x,y,z) et sa quantité de mouvement (px,py,pz). Il peut être représenté par un point dans un espace à 6 dimensions, appelé espace des phases. En mécanique classique, toute position ou toute vitesse est a priori possible. Néanmoins, il peut être utile de diviser l'espace des phases en petits volumes. La figure suivante montre le principe d'une telle subdivision pour une particule se déplaçant sur un seul axe :

Figure pleine pagePour la particule représentée par le point, on attribue un état discret correspondant à la case occupée. La discrétisation de l'espace des phases est un moyen de faire des calculs statistiques, mais il correspond aussi à une réalité physique dans le cadre de la mécanique quantique.

On procède de la même manière pour l'espace à 6 dimensions représentant l'état d'une particule. La distance Δx définissant l'intervalle de position doit être d'échelle mésoscopique. Un volume mésoscopique est petit à l'échelle macroscopique, mais comporte tout de même un très grand nombre d'atomes. Pour un gaz à pression atmosphérique, un cube de 1 μm de côté est un volume mésoscopique. L'échelle mésoscopique est donc la plus petite échelle qui permette de définir des grandeurs thermodynamiques, comme la densité ou la température.

On appelle micro-état l'état du système à un instant donné. Dans le cas présent, un micro-état est défini par les 6N variables que sont les positions et les vitesses des particules. Un microétat est donc représenté par un point dans un espace des phases à 6N dimensions. Cet espace peut être aussi discrétisé, c'est-à-dire divisé en cellules élémentaires à 6N dimensions. Dans ce cas, le micro-état est défini par la cellule occupée.

On appelle macro-état (ou état thermodynamique), l'état du gaz tel qu'il est observé à l'échelle macroscopique. Dans le cas présent, si le gaz est à l'équilibre, le macro-état est simplement défini par l'énergie E et le volume V.

D'une manière générale, un macro-état est défini par un petit nombre de variables, alors qu'un micro-état est défini par un nombre de variables extrêmement grand. L'objectif de la thermodynamique statistique est d'expliquer les observations macroscopiques à partir des micro-états.

Pour revenir au modèle du gaz parfait, on remarque que l'énergie d'interaction entre les atomes est négligée. Cela ne signifie par qu'il n'y a pas d'interactions entre les atomes. Il y a bien des interactions, sous forme de collisions, qui permettent au gaz d'atteindre un état d'équilibre thermodynamique, mais elles ont une contribution négligeable à l'énergie totale. C'est toujours en ce sens qu'on entend l'hypothèse de particules indépendantes.

1.b. Approche probabiliste

Pour un macro-état donné, le système passe sans arrêt d'un micro-état à un autre à cause du mouvement des atomes. Pour un gaz à température ambiante, le nombre de micro-états parcourus pendant une seconde est même extrêmement grand (on peut en principe les dénombrer grace à la discrétisation). La thermodynamique statistique repose sur une première hypothèse, appelée hypothèse ergodique :

Dans le cas présent, il s'agit de tous les microétats pour lesquels les atomes sont dans le volume V et ont l'énergie E.

Dans la réalité, un gaz est effectivement ergodique, même si le temps de parcours dépend beaucoup du volume.

Une fois cette hypothèse faite, on adopte une approche probabiliste, qui a été inventée par Boltzmann (physicien autrichien 1844-1906), et développée par Gibbs (physicien américain 1839-1903). Cette approche consiste à considérer les micro-états du système de manière probabiliste, sans se préoccuper de la dynamique, c'est-à-dire de la manière dont le système passe d'un micro-état à un autre. L'hypothèse fondamentale est la suivante :

Dans notre exemple, cela signifie que le système a la même probabilité de se trouver dans toutes les cellules de l'espace des phases. On définit alors Ω(N,V,E) le nombre de micro-états qui obéissent aux contraintes imposées au système (volume et énergie fixés). Il s'agit bien évidemment d'un nombre extrêmement grand. Boltzmann a défini l'entropie statistique par :

Pour un système isolé en évolution, l'accroissement de l'entropie (second principe de la thermodynamique) correspond à une augmentation du nombre de micro-états accessibles, ce que l'on désigne souvent par augmentation du désordre moléculaire. Dans ce cours d'introduction, nous n'allons pas utiliser directement l'entropie. Nous la mentionnons ici en raison de sa grande importance. C'est l'entropie qui permet de relier l'approche probabiliste aux grandeurs thermodynamiques classiques.

2. Distribution de Boltzmann

2.a. Atmosphère isotherme

Dans le gaz parfait considéré ci-dessus, il est possible de définir une densité locale n (nombre d'atomes par unité de volume), en se plaçant à l'échelle mésocopique. Lorsque le gaz n'est soumis à aucune force extérieure, cette densité est uniforme, égale à :

Pour voir comment la densité est modifiée en présence d'un champ de force, considérons le cas du champ de pesanteur (uniforme). Le modèle utilisé est celui de l'atmosphère isotherme (l'atmosphère réelle n'est pas du tout isotherme). En raison de la pesanteur, la pression du gaz (parfait) dépend de l'altitude z. Considérons une couche de gaz mésoscopique comprise entre les altitudes z et z+dz, d'aire A. La figure suivante représente les trois forces qui agissent sur cette portion de gaz (ρ est la masse volumique).

Figure pleine pageL'équilibre mécanique s'écrit :

On introduit la densité locale n et la masse m d'une molécule :

ce qui conduit à l'équation différentielle :

L'équation d'état du gaz parfait s'écrit :

où est la constante de Boltzmann. On a donc l'équation différentielle pour la densité :

Si le gaz est à l'équilibre thermique (atmosphère isotherme), l'intégration de cette équation donne :

L'argument de l'exponentielle est l'opposé du rapport de l'énergie potentielle d'un atome sur l'énergie thermique kT.

2.b. Probabilité d'un l'état d'une particule

En l'absence de champ de force, un atome du gaz parfait a la même probabilité de se trouver dans tous les points du volume (dans toutes les cases de l'espace discrétisé). Il n'en est plus de même en présence d'un champ de force extérieur. La densité obtenue dans le modèle de l'atmosphère isotherme nous suggère de définir la densité de probabilité par :

La probabilité pour un atome d'être entre z et z+dz est f(z)dz.

Le facteur exponentiel de cette expression est le facteur de Boltzmann. Il est caractéristique des systèmes en équilibre thermique à la température T.

La constante C est déterminée en écrivant la normalisation de la probabilité : la somme de toutes les probabilités doit être égale à 1. Pour une densité de probabilité, on écrit :

où H est la hauteur du volume V.

Cette relation se généralise à une particule dans un système dont la température est T. On suppose que les états de la particule sont dénombrables. Pour l'atome du gaz parfait, on y parvient en utilisant la discrétisation de l'espace des phases. On peut alors exprimer la probabilité pour qu'une particule soit dans un état donné. On désigne par la lettre α un état donné de la particule, par exemple une cellule de l'espace des phases à 6 dimensions. La loi de distribution de Boltzmann est la suivante :

La constante C se détermine en écrivant que la somme des probabilités sur tous les états de la particule est égale à 1 :

Cette loi de probabilité est appelée distribution de Boltzmann. Si N est le nombre de particules du système, le nombre moyen de particules dans un état donné est :

Pour une justification de cette distribution, voir Distribution de Boltzmann (complément hors programme). Voir aussi Simulation de Monte-Carlo d'un système à énergie constante.

Il faut bien faire attention à comprendre cette expression comme la probabilité pour la particule d'être dans un état donné, et non pas d'avoir une énergie donnée. En effet, il arrive fréquemment que plusieurs états aient la même énergie. C'est le cas dans le modèle de gaz parfait considéré plus haut. Par exemple, pour une particule se déplaçant dans un espace à une dimension sans force extérieure, tous les états de même quantité de mouvement ont la même énergie.

Figure pleine pageUn niveau d'énergie auquel correspondent plusieurs états est appelé niveau d'énergie dégénéré. Dans cet exemple, le nombre d'états pour chaque niveau d'énergie est indépendant de ce niveau, donc la distribution des niveaux d'énergie vérifie aussi la distribution de Boltzmann (seule la constante C change). Ce n'est plus le cas si l'on considère les états représentés sur la figure suivante :

Figure pleine pageÀ énergie constante, un niveau d'énergie dégénéré a une probabilité plus forte qu'un niveau non dégénéré.

Pour reprendre l'exemple de la particule dans l'espace à une dimension, on remarque que l'introduction d'une énergie potentielle de la forme -mgx modifie l'énergie des états en fonction de leur position x. Ce phénomène est appelé levée de dégénérescence.

La probabilité de la distribution de Boltzmann décroît exponentiellement avec l'énergie. Cela signifie que les états de plus faible énergie sont les plus probables. Plus la température est élevée, moins la décroissance est rapide.

Comparons les probabilités de deux états :

L'état d'énergie le plus faible est toujours le plus probable, mais l'écart se réduit si l'on augmente la température. Plus précisément, si kT<ε, l'état de plus faible énergie est beaucoup plus probable. Si , les deux états ont des probabilités très voisines.

2.c. Système en équilibre avec un thermostat

La distribution de Boltzmann se généralise à un système quelconque en équilibre thermique avec un thermostat (ou source de chaleur) de température T. Ce type de système n'est pas isolé, puisqu'il échange de l'énergie avec le thermostat. A priori, son énergie totale E n'est donc pas constante. Désignons par la lettre μ un micro-état de ce système. La probabilité de ce micro-état s'écrit :

où Eμ est l'énergie du système pour ce micro-état. La constante est déterminée en écrivant la somme sur tous les micro-états :

La particule considérée précédemment n'est qu'un cas particulier, car la particule est en équilibre thermique avec le reste du système qui constitue un thermostat (s'il est assez grand).

La précaution signalée plus haut sur les niveaux d'énergies dégénérés est très importante dans le cas général, car les niveaux d'énergie d'un système comportant plusieurs particules sont toujours dégénérés, et le nombre d'états dépend fortement du niveau d'énergie. Pour un système à N particules, il augmente en gros comme EN. Lorsque N est grand, l'augmentation avec l'énergie du nombre d'état correspondant est donc très rapide. La probabilité pour que le système ait une énergie E est :

où Ω(E) est le nombre de micro-états ayant l'énergie E.

2.d. Calculs statistiques

Soit une grandeur physique Xμ qui dépend du micro-état. La distribution de Boltzmann permet de calculer la valeur moyenne de cette grandeur (c'est-à-dire son espérance) :

Par exemple, la valeur moyenne de l'énergie du système est :

Un autre grandeur importante est la variance, qui indique la dispersion des valeurs autour de la valeur moyenne. La variance est la moyenne du carré de l'écart entre X et sa valeur moyenne :

L'expression de la variance se développe :

Comme la valeur moyenne est en général déjà connue, on calcule la variance à l'aide de la valeur moyenne du carré de X.

On appelle écart quadratique moyen (ou écart-type), la racine carrée de la variance :

L'écart-type peut être comparé directement à la valeur moyenne, et donne une information sur la dispersion des valeurs autour de la moyenne. Si le rapport

est faible alors l'énergie du système reste très probablement très proche de sa valeur moyenne. On verra plus loin que c'est le cas lorsque le nombre de particules est grand. Pour une particule individuelle, l'écart-type est du même ordre que la moyenne, ce qui indique une très forte dispersion.

Les calculs statistiques sont facilités en posant :

Z est la fonction de partition du système. Si l'on dispose d'une expression de Z, on peut faire tous les calculs statistiques. Par exemple :

En dérivant deux fois la fonction de partition par rapport à β, on obtient la variance de l'énergie :

On a donc :

Cette expression peut s'écrire en introduisant la capacité thermique à volume constante :

Le calcul conduit à

Ainsi la variance est proportionnelle à la capacité thermique à volume constant. Le rapport entre l'écart-type et la valeur moyenne est alors :

L'énergie moyenne et la capacité thermique sont deux grandeurs extensives proportionnelles à N. On en déduit la loi d'échelle :

L'écart-type relatif est donc d'autant plus faible que le système est grand. Pour un système thermodynamique macroscopique, cet écart relatif est extrêmement faible, ce qui signifie que l'énergie du système reste très probablement très proche de son énergie moyenne. Ainsi un système thermodynamique en équilibre avec un thermostat est similaire à un système isolé d'énergie constante (tant qu'il reste à l'équilibre).

3. Système de particules indépendantes à énergies discrètes

3.a. Définition

On considère un système formé de N particules indépendantes et discernables. Pour chaque particule, il y a M états possibles, numérotés de 0 à M-1. À chaque état m est associée une énergie εm. Pour simplifier, on suppose que ces niveaux d'énergie sont régulièrement espacés, et on note ε le quantum d'énergie.

Un exemple physique de système de ce type est un cristal, dont chaque atome est modélisé par un oscillateur harmonique. On démontre en mécanique quantique que l'énergie de l'état m d'un oscillateur harmonique est :

On suppose ici que tous ces oscillateurs sont indépendants, ce qui n'est pas exact dans un cristal réel.

Le modèle de gaz parfait évoqué plus haut peut aussi être représenté de cette manière, dans la mesure où son espace des phases est discrétisé.

La figure suivante montre les niveaux d'énergie de quelques particules du système. Les niveaux d'énergie sont non dégénérés.

Figure pleine pageLes particules sont indépendantes dans le sens où l'énergie d'interaction entre les particules est négligeable devant l'énergie des particules. Il y a tout de même des petites interactions entre particules qui permettent au système d'atteindre l'équilibre thermodynamique. Par exemple, pour un gaz parfait, il y a des collisions entre molécules qui permettent d'atteindre l'équilibre, bien que l'énergie potentielle d'interaction soit négligeable.

3.b. Moyenne et écart-type de l'énergie d'une particule

La probabilité que la particule soit dans l'état m est :

L'énergie moyenne d'une particule est donc :

Lorsque les niveaux d'énergie sont équidistants, la fonction de partition d'une particule se calcule aisément en introduisant l'espacement ε des niveaux d'énergie :

On en déduit l'énergie moyenne d'une particule :

Lorsque le nombre de niveaux d'énergie est assez grand et kT faible par rapport au dernier niveau, on peut simplifier ce résultat en considérant la limite , ce qui élimine le dernier terme.

La variance est :

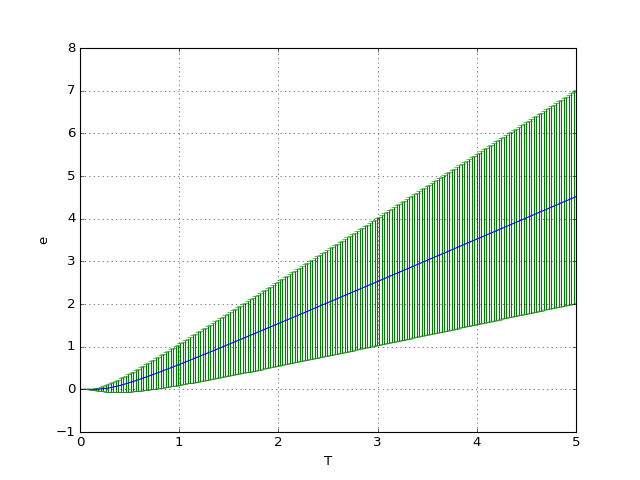

Pour tracer l'énergie moyenne en fonction de la température, on adopte les valeurs k=1 et ε=1. Le premier niveau est choisi nul (il suffit de l'ajouter à la valeur moyenne). L'écart type est représenté sous forme de barres d'erreur.

On commence par le cas où le nombre d'états M est très grand :

from matplotlib.pyplot import *

import numpy

def moy_e(M,T):

return 1.0/(numpy.exp(1.0/T)-1)-M/(numpy.exp(M/T)-1)

def var_e(M,T):

return numpy.exp(1.0/T)/(numpy.exp(1.0/T)-1)**2\

-M**2*numpy.exp(-M/T)/(1-numpy.exp(-M/T))**2

def ecart_e(M,T):

return numpy.sqrt(var_e(M,T))

def Cv(M,T):

return var_e(M,T)/T**2

T = numpy.linspace(0.01,5,200)

figure()

M=1000

e1 = moy_e(M,T)

de1 = ecart_e(M,T)

plot(T,e1)

errorbar(T,e1,yerr=de1/2,fmt=None)

xlabel("T")

ylabel("e")

grid()

figA.pdf

figA.pdf

Lorsque l'énergie thermique kT est petite par rapport à la différence ε, la probabilité est négligeable pour les états , et donc l'énergie moyenne est égale à ε0 et la variance est nulle. Si au contraire l'énergie thermique est grande devant l'écart entre deux niveaux d'énergie consécutifs, des états différents peuvent être occupés et la variance est grande.

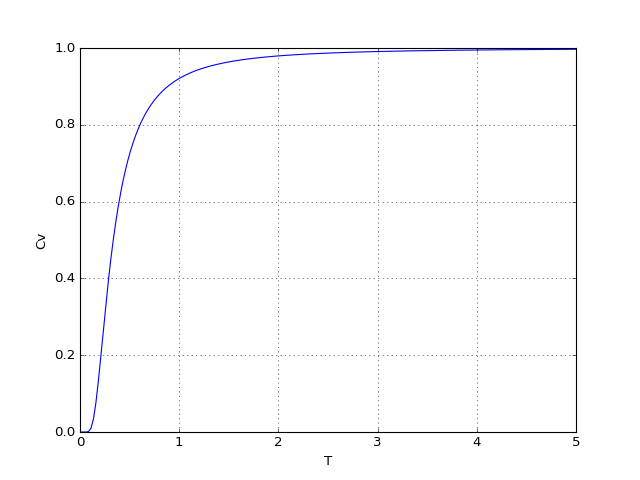

Voyons le tracé de la capacité thermique :

cv1 = Cv(M,T)

figure()

plot(T,cv1)

xlabel("T")

ylabel("Cv")

grid()

figB.pdf

figB.pdf

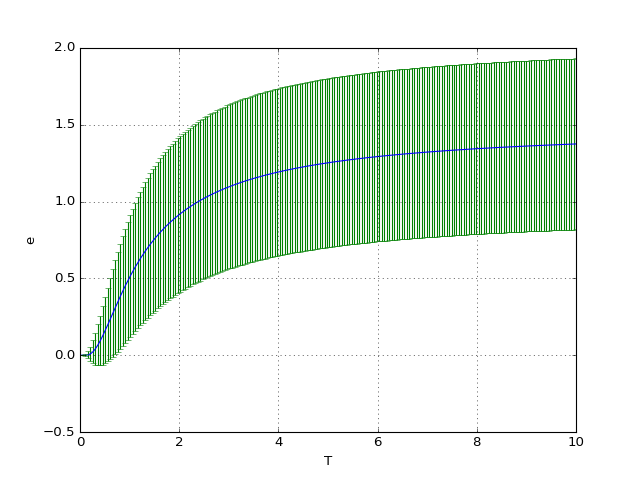

Voyons ce qu'on obtient pour un nombre de niveaux d'énergie limité, c'est-à-dire lorsque le dernier niveau d'énergie peut être occupé dans la gamme de température considérée. Dans l'exemple ci-dessous, il y a seulement 4 niveaux d'énergie.

M=4

T = numpy.linspace(0.01,10,200)

figure()

e1 = moy_e(M,T)

de1 = ecart_e(M,T)

plot(T,e1)

errorbar(T,e1,yerr=de1/2,fmt=None)

xlabel("T")

ylabel("e")

grid()

figC.pdf

figC.pdf

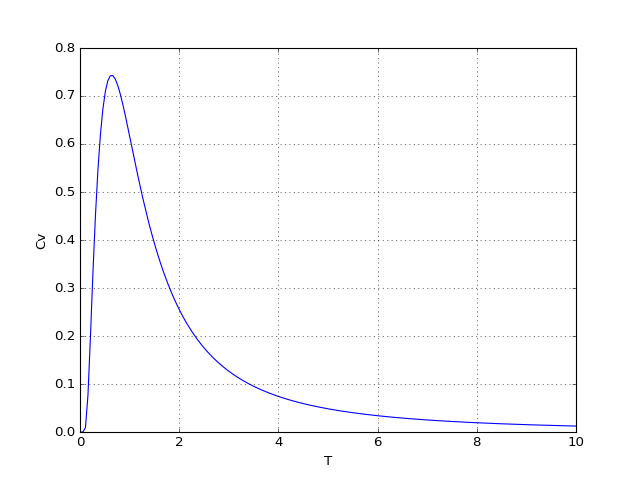

À haute température, tous les états des particules sont équiprobables. L'énergie moyenne tend vers la moitié de l'énergie maximale.

cv1 = Cv(M,T)

figure()

plot(T,cv1)

xlabel("T")

ylabel("Cv")

grid()

figD.pdf

figD.pdf

3.c. Moyenne et écart-type de l'énergie du système

Considérons à présent le système en entier, comportant N particules. Pour une énergie E donnée, il y a plusieurs micro-états qui ont cette énergie, et même un très grand nombre si N est grand. La valeur moyenne de l'énergie du système s'écrit :

Pour écrire la fonction de partition Z, il faut considérer une somme sur tous les micro-états, c'est-à-dire une somme multiple sur les nombres mi de toutes les particules :

En écrivant la somme sous cette forme, on a utilisé implicitement le fait que les particules sont discernables. Pour un système quantique, les particules identiques sont indiscernables et la somme doit être calculée différemment. On voit que la fonction de partition se factorise de la manière suivante :

La fonction de partition du système est simplement le produit des fonctions de partition des particules. Cette propriété vient du fait que les particules sont indépendantes. Puisque toutes les particules sont identiques, on a finalement :

L'énergie moyenne est :

Pour des particules indépendantes, l'énergie moyenne est donc égale au nombre de particules multipliée par l'énergie moyenne d'une particule.

La variance est :

La variance pour le système est donc égale à la variance pour une particule multipliée par N. On en déduit le rapport de l'écart quadratique moyen sur la moyenne :

L'écart relatif diminue comme l'inverse de la racine carrée du nombre de particules. Ce résultat n'est d'ailleurs pas spécifique à la distribution de Boltzmann. Il s'applique de manière générale à N variables aléatoires indépendantes.

Pour un système thermodynamique, où N est de l'ordre du nombre d'Avogadro, l'écart relatif est infime. Autrement dit, l'énergie du système en équilibre avec un thermostat est pratiquement constante. À l'équilibre, un système isolé est pratiquement identique à un système à température constante. D'une manière générale, les grandeurs physiques ont une très faible variance dans un système thermodynamique à l'équilibre.

La simulation de Monte-Carlo Distribution de Boltzmann : particules indépendantes montre des tirages aléatoires pour ce système à N particules.

3.d. Système à deux niveaux

On considère le cas particulier d'un système à deux niveaux, c'est-à-dire dont les particules ont deux niveaux d'énergie (M=2). De nombreux systèmes quantiques peuvent être modélisés, au moins en première approximation, par un système à deux niveaux. Un exemple est un modèle du paramagnétisme, consistant à attribuer à chaque particule (par exemple les atomes d'un cristal) un spin 1/2. Dans un champ magnétique , la composante du moment magnétique de ces atomes sur z ne peut prendre que deux valeurs +μ et -μ (voir expérience de Stern et Gerlach). Chaque particule a donc deux états, l'un d'énergie ε0=-μB, l'autre d'énergie ε1=+μB.

Un système à M niveaux non régulièrement espacés (comme un atome) peut éventuellement être modélisé par un système à deux niveaux lorsque ses deux premiers niveaux ont une énergie beaucoup plus basse que le troisième. Si la température n'est pas suffisante pour peupler le troisième niveau, on peut considérer seulement les deux premiers.

On peut appliquer les résultats déjà établis pour M quelconque, mais il est instructif de refaire les calculs. Par convention, on pose ε0=0. Le second niveau d'énergie est donc ε1=ε. La probabilité des deux états est :

L'énergie moyenne des particules est :

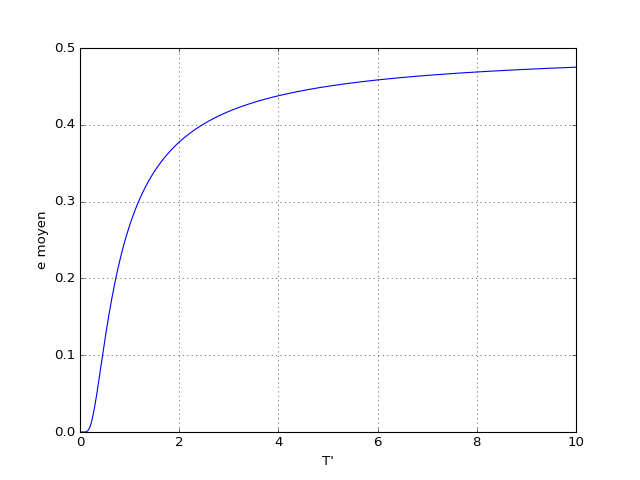

Voyons la courbe en fonction de T. La température sans dimensions utilisée pour les figures est définie par T'=kT/ε.

def e(T):

x = numpy.exp(-1.0/T)

return x/(1+x)

figure()

T = numpy.linspace(0,10,500)

plot(T,e(T))

xlabel("T'")

ylabel("e moyen")

grid()

figE.pdf

figE.pdf

On peut distinguer deux comportements limites. À haute température () les deux états sont équiprobables. Il y a autant de particules dans un état que dans l'autre et donc :

À basse température (), le premier niveau est beaucoup plus peuplé que le second et

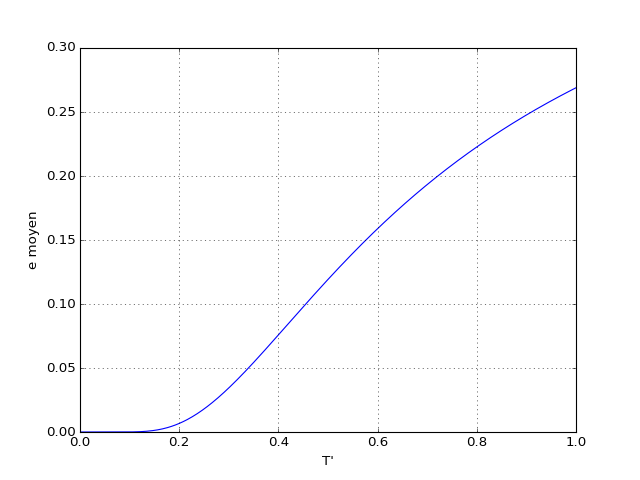

Voyons la courbe à basse température :

figure()

T = numpy.linspace(0,1,500)

plot(T,e(T))

xlabel("T'")

ylabel("e moyen")

grid()

figF.pdf

figF.pdf

À très basse température (), seul le niveau de basse énergie est peuplé, car la probabilité pour une particule d'être dans l'autre état est négligeable.

L'énergie moyenne du système est :

Calculons sa capacité thermique :

On peut sans difficulté faire ce calcul, mais considérons plutôt les deux cas limites. À basse température, on obtient :

La capacité est pratiquement nulle lorsque . La variance est :

On retrouve l'évolution de l'écart-type moyen avec le nombre de particules :

Lorsque N est très grand, l'énergie totale du système a une très faible probabilité de s'éloigner de sa valeur moyenne. Pour un système ergodique, cela signifie que les fluctuations temporelles de l'énergie sont très faibles.

À haute température, l'énergie tend vers une valeur constante donc la capacité thermique tend vers zéro.

4. Systèmes à énergie continue

4.a. Gaz parfait monoatomique classique

On reprend le modèle de gaz parfait monoatomique défini plus haut. L'énergie d'un atome se limite à son énergie cinétique de translation :

où l'on a introduit les composantes de la quantité de mouvement sur trois axes.

Le modèle de gaz parfait classique (dans le sens de non quantique) consiste à considérer que cette énergie cinétique varie de manière continue. Cela revient à faire tendre ε vers zéro. On remplace donc les cellules de l'espace des phases par des volumes infinitésimaux. Dans ce cas, on utilise une densité de probabilité. La probabibilité pour une particule d'avoir une quantité de mouvement dans l'intervalle (px,px+dpx),(py,py+dpy),(pz,pz+dpz) est :

La condition de normalisation s'écrit :

Il s'agit d'une intégrale triple, les composantes des quantités de mouvement variant de moins l'infini à plus l'infini. On remarque que cette intégrale ce factorise en trois intégrales identiques :

Considérons la moyenne de l'énergie cinétique pour un degré de liberté, par exemple l'énergie cinétique pour l'axe x :

En développant l'exponentielle, l'intégrale se factorise en trois intégrales indépendantes. On obtient finalement :

En faisant le changement de variable on obtient :

ce qui conduit à :

L'énergie cinétique moyenne d'un atome est donc 3/2kT. On en déduit l'énergie du gaz

puis sa capacité thermique :

En introduisant le nombre de moles, on retrouve la capacité molaire classique 3/2R.

4.b. Théorème d'équipartition de l'énergie

Le résultat précédent se généralise à toute forme d'énergie qui est quadratique par rapport à un degré de liberté.

Considérons comme exemple un gaz parfait formé de molécules diatomiques. L'énergie d'une molécule comporte son énergie cinétique de translation et son énergie cinétique de rotation. Pour la rotation, il y a deux degrés de libertés, car il faut deux angles pour définir la position d'une molécule diatomique dans l'espace (il y a invariance par rotation autour de son axe). Les degrés de liberté de rotation sont quadratiques par rapport à la vitesse angulaire. Par exemple, pour la rotation autour d'un axe fixe :

où I est le moment d'inertie de la molécule autour de l'axe de rotation. Dans ce cas, il y a deux dimensions supplémentaires dans l'espace des phases, correspondant à l'angle et à la vitesse angulaire.

Pour un gaz parfait diatomique, il y a donc 5 degrés de liberté à énergie quadratique par molécule. Le théorème d'équipartition de l'énergie nous donne alors l'énergie moyenne par molécule :

On en déduit la capacité molaire 5/2R d'un gaz parfait diatomique classique.

4.c. Modèle classique des solides

Dans un solide, les atomes (ou les ions) du réseau cristallin ont une position moyenne fixe mais vibrent légèrement autour de cette position sous l'effet des forces exercées par les atomes voisins. Comme les déplacements sont faibles (par rapport aux distances interatomiques), on peut appliquer un modèle classique avec des forces de rappel linéaires. En première approximation, on peut considérer que chaque atome constitue un oscillateur harmonique indépendant. Soit K0 le coefficient de raideur, qui relie le déplacement à la force. L'énergie pour cet oscillateur est la somme d'une énergie cinétique de translation et d'une énergie potentielle élastique :

Pour l'axe x, il y a en fait deux degrés de liberté (on raisonne dans l'espace des phases), un pour la quantité de mouvement, l'autre pour la position. On a ici un exemple d'une énergie qui dépend de deux variables. Les niveaux d'énergie sont donc dégénérés. Puisque les deux formes d'énergie sont quadratiques par rapport au degré de liberté correspondant, la moyenne est :

Pour les trois dimensions de l'espace, cela fait une énergie moyenne 3kT, d'où l'on déduit la capacité thermique molaire du solide :

C'est la loi de Dulong et Petit, qui a été constatée expérimentalement bien avant le développement de la thermodynamique statistique. En fait, ce résultat n'est valable qu'à haute température (en gros au dessus de 300 K). Lorsque la température décroît, la capacité thermique diminue. Cette propriété ne peut être expliquée que par un modèle quantique, introduit par Einstein en 1907, qui s'est appuyé pour cela sur les découvertes de Planck à propos du rayonnement du corps noir. Le modèle de particules indépendantes à énergies discrètes conduit en effet (voir courbes plus haut) à une capacité thermique tendant vers zéro à basse température. Cela vient du fait que, à très basse température, seul le niveau de plus basse énergie est peuplé. L'énergie du solide devient alors indépendante de la température. En reprenant l'hypothèse de Planck sur la quantification de l'énergie, Einstein a montré que les courbes de capacité thermique en fonction de la température pouvaient s'expliquer par l'introduction d'un quantum d'énergie :

La pulsation de l'oscillateur est reliée aux paramètres classiques par :

C'est effectivement le résultat qui est obtenu pour un oscillateur harmonique en mécanique quantique : les niveaux d'énergie sont discrets, avec un espacement constant entre deux niveaux consécutifs.